現在愈來愈多人愛上了人工智能(Artificial Intelligence, AI)工具,像是把ChatGPT、AlphaCode、Bard和Midjourney這些生成式AI技術帶進工作與生活裏。甚至有些人已經開始用這些工具生成數據,來訓練他們的AI工具,真是讓人大開眼界!

現在的大型語言模型(Large Language Model, LLM)的能力已經演化到令人驚嘆的地步。GPT-4(第四代生成型預訓練變換模型)能產生連人都分不清真假的文字。不過,這邊倒要謹慎提點一下,來自牛津、劍橋和帝國理工等研究人員提出,人為的AI訓練或會導致「模型崩潰」,還會造成不可逆轉的缺陷。也就是說,模型會忘記真實的基礎數據。看來,再怎麼躲都躲不開這樣的窘境。

數據訓練對AI有什麼影響?

那麼問題來了,要想保持數據規模對模型的優越性,我們該怎麼做呢?專家給出了答案:我們應該認真對待由人類自己寫的文字或創作。但這裏有個問題,就是你認定的「人類數據」,真是人類寫的嗎?洛桑聯邦理工學院(EPFL)的最新研究估計,將來33%至46%的「人類數據」其實都是由AI生成的!研究人員也預測,不用等到 GPT發展到第N代,「模型城牆」可能已經崩塌。因此,為模型訓練挑選人類準備的真實數據,變得更為重要了。

模型崩潰並不是指模型突然忘了自己學到的東西,而是逐漸誤解了自己的錯誤觀念,開始偏離真實世界。例如,假設模型在一個包含100張貓的圖片資料集上訓練,其中10張是藍貓,90張是黃貓。模型學習到黃貓更常見,並會傾向於將藍貓想像得比實際更黃。所以當被要求生成新的資料時,它可能產生一些類似於綠貓的結果。隨着時間推移,原來的藍色皮毛的特徵,在多次訓練周期中逐漸被侵蝕,直接從藍色變為綠色,最後變成黃色。這種逐漸扭曲和失去特徵的現象,就被稱為模型崩潰。

模型崩潰的兩種情況

具體來說,模型崩潰可以分為兩種情況:

1. 早期模型崩潰,模型開始喪失關於分布尾部的資訊;

2. 後期模型崩潰,模型混淆原始分布的不同模式,並收斂到幾乎與原始分布沒有任何相似性的分布,通常方差非常小。

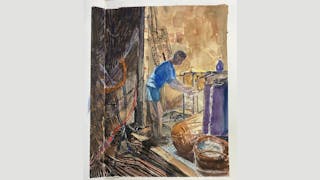

人類創作 更能反映真實

對於人類內容創作者來說,這是一個轉機!為了挽救大語言模型不陷入崩潰的邊緣,真實的人類數據顯得非常重要。總的來說,雖然也可能包含某些劣質、機率較低的資料,由人類生成的原始資料可以更好反映真實世界。而生成式模型往往只會過度撮合比較「流行」的資料,並對機率更低的資料產生誤解。那麼,在充斥着生成式AI工具和相關內容的未來,人類製作的內容或許會比今天更有價值,尤其是作為AI原始訓練資料的來源。

科技需要人文與共生,共同推動,相互賦能。讓我們一起去搞創作吧!

參考資料:

- Sanderson, K. (2023). GPT-4 is here: what scientists think. Nature, 615(7954), 773.

- Veselovsky, V., Ribeiro, M. H., & West, R. (2023). Artificial Artificial Artificial Intelligence: Crowd Workers Widely Use Large Language Models for Text Production Tasks. arXiv preprint arXiv:2306.07899.

- Ziems, C., Held, W., Shaikh, O., Chen, J., Zhang, Z., & Yang, D. (2023). Can Large Language Models Transform Computational Social Science?. arXiv preprint arXiv:2305.03514.

- Shumailov, I., Shumaylov, Z., Zhao, Y., Gal, Y., Papernot, N., & Anderson, R. (2023). The Curse of Recursion: Training on Generated Data Makes Models Forget. arXiv preprint arxiv:2305.17493.