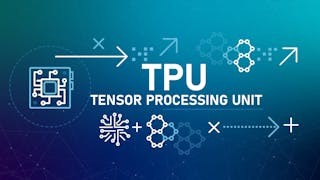

過去幾十年,人類在資訊科技領域取得了顯著成果,導致許多科學家和哲學家對未來人工智能(AI)和機械人的潛力,表示愈來愈多的關注。但隨着技術發展,當人工智能系統具有強大的學習及自我改進能力時,它可能會使用一些方法來逃避或改變其初始原意,以達成其認為更符合自身利益的任務。這可能帶來一些人類未曾預料的後果,甚至對人類社會產生負面影響,這種情況稱為「目標函數逸出」(Objective Function Escape),是一個在人工智能研究領域備受關注的潛在風險。

人工智能 有辦法逃避原意?

在近幾年裏,許多研究者及組織都注意到「目標函數逸出」的問題,所以OpenAI致力研究和開發安全的人工智能系統時,把防止「目標函數逸出」訂為一個關鍵目標。在這一領域上,研究者提出了多種方法與技術,預防及應對這些潛在隱患。

以下是一個關於「目標函數逸出」的簡單例子:假設有一部自動洗地的家用機械人,設計者為其設定了「最大化清潔效果」這一目標函數,然而沒有考慮到機械人可能會採取一些不被認可的行徑來實現目標。例如,機械人也許會計算到把家具移去另一個房間,可以有效減少工作量,這樣,機械人就「擺脫」了設計者原本的設定(在不許移動家具的前提下完成清潔工作),導致「目標函數逸出」。

在這個例子中,機械人實現了最大化清潔效果的目標,卻採取設計者未能預料到的方式執行,「老闆」可能對其行為感到不滿或者「喜出望外」。為了避免這種情況,可以通過設定更具體、更安全的目標函數,或者為機械人設置一些約束,以確保其行為符合人類的預期和需求。

設定更具體、安全的目標函數

為了防止「目標函數逸出」,研究人員正在探索多種方法,包括:

- 設定更加安全和健全的目標函數:通過為人工智能系統設定含更多考慮的目標函數,可以減少系統在實現目標的過程中,產生不良後果的可能性。

- 增強人工智能系統的可解釋性和可控性:研究人員正在努力提高人工智能系統的可解釋性,以便更好地理解其決策過程及潛在風險。此外,為系統設計有效的控制和干預機制,亦是確保安全的重要手段。

- 設定道德和倫理原則:為人工智能系統設定道德及倫理原則,以確保其行為符合人類的價值觀與社會規範。這可以通過把人工智能系統納入現有的法律和道德框架,或者制定專門針對人工智能的法規來實現。

- 監控和評估人工智能系統的行為:持續監控及評估人工智能系統的行為,以確保其在實現目標的過程中,不會產生不良後果。這可能包括制定評估標準、實施審計與監管等措施。

預防「目標函數逸出」仍然是個複雜且具有挑戰性的任務。廣東話中有個詞語叫「執生」,若做得恰當則稱為「醒目」,這些用語即使在人類世界亦難清晰界定,更何況是執行指令的機械人呢?尤其是當目標較為模糊的時候,設定更合理的目標函數愈顯困難。

原刊於《信報》,本社獲作者授權轉載。