若然銷售員向你推薦某件產品卻沒有給你合適的理由,又或者醫生在判斷你患上危疾時沒有向你解釋箇中原因,相信任何人遇到上述情況都難以接受。不過,這情況在現今世界卻愈來愈普遍。

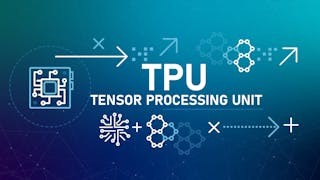

在全球新冠肺炎疫情肆虐之下,數碼經濟大行其道,線上服務已成為普羅大眾日常生活一部分,例如網上購物、電子醫療等服務廣受歡迎。這些系統所具備的先進功能,是利用深度學習技術,為客戶提供貼身的人工智能服務。然而,深度學習以「點對點」(P2P)和「黑箱」(Black Box)形式進行,所以系統輸出的答案一般是無法解釋的,令用戶摸不着頭腦,「用戶友善」(User Friendly)度甚低。

系統精準度 視乎訓練集

針對這個問題,電腦科學家着手研發「可解釋人工智能」(Explainable AI,XAI)技術。顧名思義,其任務是有系統地去了解究竟深度學習算法如何產生某個特定結果。較多人使用的「可解釋人工智能」算法是從訓練數據集當中,找出對結果有最大貢獻的樣本,然後從該樣本抽取出特徵作為解釋。例如,訓練集中有3張圖片:金魚、麻雀和螞蟻,分別代表魚、鳥和蟲類動物,基於此集而訓練產生的人工智能系統,會把一張燕子的圖片定性為鳥類,透過「可解釋人工智能」技術,專家可了解到這決定主要是因為輸入的圖片(燕子)是受到訓練集中麻雀那張圖片的影響;進一步分析兩張圖片,專家發現兩者有着共同的特徵,包括翅膀、喙等;就此,專家便可以解釋燕子是鳥類動物因為它有翅膀和喙。

在實際環境中,訓練集是超大規模的(遠遠多過3張圖片),「可解釋人工智能」技術要從中挖掘出最具影響力的樣本殊不容易,這正是電腦科學家的研究重點。其中一個折衷的方法是重用訊息,科學家可以把每一次分析的結果結合成為一個智識庫(Knowledge Base)。如此這般,系統運作時間愈長,智識庫內所建立的資料便愈豐富,「解釋」的效率同時亦會愈高。再者,系統所建立的智識庫理論上是通用的,可以應用於其他人工智能場景,一舉多得。

數據技術員及檢測員吃香

以上討論的前設是,人工智能系統所輸出的結果是對的,惟現實中系統有機會誤判。這是因為輸入的資訊(如圖片)雖然在學習過程中從來未出現過,但卻與某訓練樣本類似,例如樣本是馬,輸入是鹿,系統可能會錯誤地「指鹿為馬」。在這情況之下,「可解釋人工智能」也可派用場,它可以用作為檢測器,當找出解釋之後,讓專家評估其準確性,並進一步分析當中的錯處。公司可以使用檢測器來修改人工智能系統;政府部門也可以利用此技術,為人工智能產品檢測和認證,確保產品的安全性。

由上述可見,數據驅動(Data Driven)人工智能系統的準確性及可靠性,跟其背後的訓練數據集的質量息息相關。電腦科學入門課程中提出「垃圾入垃圾出」(Garbage In Garbage Out)是深度學習以至人工智能的基本原則。因此,人工智能工程在系統開發過程中,必須做好深度學習前期的數據搜集、篩選、標注等準備工作。這些工作是資訊科技業界應運而生的「數據技術員」、「數據檢測員」等新工種。在日益增長的全球人工智能市場下,這類工作將會愈來愈搶手。香港在這方面的職業培訓也應作好適當的準備,鞏固本港在粵港澳大灣區國際創科中心地位。

原刊於《信報》,本社獲作者授權轉載。