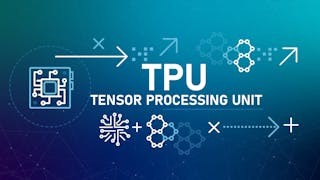

科技日新月異,隨著人工智能(AI)相關技術(包括雲計算、大數據、深度學習等)的急速發展,「機器代人」近年已成為全球熱門話題。再者,「屈臣」AI常識專家(IBM的AI系統)及「阿爾發狗」AI圍棋皇的出現,加上傳媒的大力吹捧,令普羅大眾深信「機器代人」的日子已不遠矣。

正因如此,各國企業爭相推出五花八門的AI產品及服務。與此同時,有外國學者進行另類AI研究。他們認為AI應用不能只顧科技,其背後的哲學對「機器代人」發展同樣重要,不容忽視。

道德倫理問題要解決 AI方能普及

現今的AI技術主要是針對特定應用領域而設的,例如「阿爾發狗」的目標領域是圍棋比賽。若然單是從功能(即下棋)上考慮的話,「阿爾發狗」無疑能代替人類在有關領域的操作。然而,其設計往往忽略應用中道德及倫理問題,直接影響AI的全面性及普及性。

談及AI倫理問題,其中一個重要課題是「數據歧視」(Data Discrimination)。要理解這問題,大家必須認識「機器學習」(Machine Learning,簡寫為ML)技術在AI應用研發的作用。以「阿爾發狗」為例,它之所以能夠在圍棋界稱皇,全是因為它不斷地學習,從棋譜、對手及自我等渠道牢牢記着每下一步棋之後棋盤的狀態。在一個19乘19的圍棋棋盤之上,兩個棋手在對壘期間來回下棋平均數十回,因此系統需要學習的棋盤狀態高達天文數字,其運算的複雜度不言而喻,實在非人類之所及。機器學習的運算建基於統計學,簡單而言統計學的目的是從大量訓練數據中計算出目標事件在既定條件之下可能發生的機率。例如圍棋對手每下一棋子,「阿爾發狗」便會因應棋盤的最新狀態而算出最大機會取得勝利的回應步。

機器學習偏誤會造成不公

換言之,最大機率(即最大機會)發生的事件順理成章地成為系統的首選。反言之,低機率事件往往會被忽視,或極大可能沒有任何曝光機會。這個現象就是構成數據歧視的主要原因,在現實應用中會導致嚴重的社會問題。

例如,某美國保安中心利用機器學習技術開發AI社會監察系統來分析犯罪趨勢,結果發現黑人犯罪率比其他種族高,因而導致黑人羣組被負面標簽,嚴重影響他們的社會權益及地位。黑人往往面對在街上被警察截查的比率較白人高、申請銀行貸款的批核率較低等不公平的對待。若然有一天AI真的全面代替執法者的話,不排除「機械警察」逢見黑人便跟踪追查。如此這般,人權又何在呢?

AI 哲學雖然是「機器代人」研究的關鍵議題,可惜在華人社會並未受到重視。一般華人計算機科學家只是醉心提升AI技術,把AI道德及倫理問題抛諸門外。如果人類未來被有力而無心的機器人包圍着,世界將會是多恐怖!